SEO er et af de mest afgørende faktorer for at gøre dit website synligt for brugerne. Det er vigtigt, at din hjemmeside er opsat korrekt teknisk, så det giver Google de bedste forudsætninger for at gennemgå din hjemmeside korrekt. Vi har talt med SEO-ekspert hos Conversio, Jonas Venning Larsen om hvordan du selv kan gøre en forskel.

Fungerer din hjemmeside teknisk i forhold til SEO, så giver det grundlaget for langt større succes med de andre SEO-tiltag såsom ‘content’ og ‘linkbuilding’ du laver. Der er et stort antal af tekniske elementer, der skal være i orden. I dag kigger vi nærmere på hastighed, robots.txt og XML-sitemap.

Hastighed

De fleste er allerede bekendte med, at en hurtig hjemmeside er altafgørende for brugervenligheden. Men det er også vigtigt i forhold til SEO. Google lægger stor vægt på, at tilbyde de bedste resultater, hvilket også indebærer brugervenlige sider.

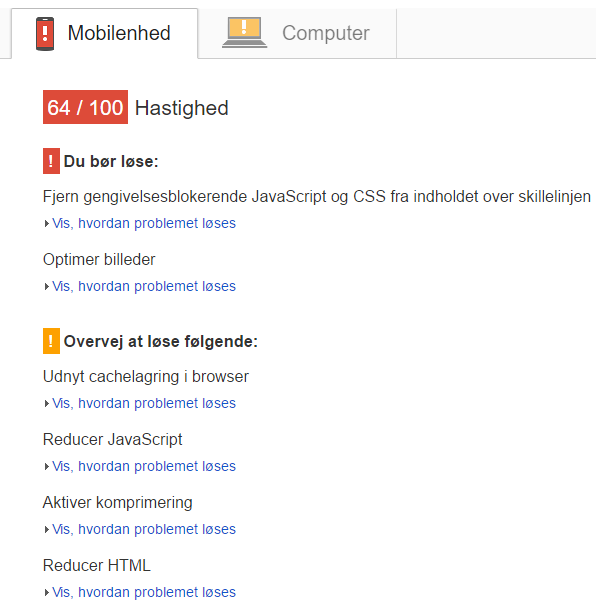

Google har udviklet PageSpeed Insights, der giver mulighed for at måle, hvor godt konkrete sider er hastighedsoptimeret. Fordelen ved værktøjet er, at det giver konkrete løsningsforslag til, hvordan hastigheden kan optimeres. En hjemmeside kan godt være relativt hurtig og alligevel have en mindre god score ifølge Google. Derfor er det stadig vigtigt at løse problemstillingerne, der fremkommer i testen. Dette skyldes, at Google i høj grad vurderer din hjemmeside ud fra, hvordan dine sider opfylder de krav, de selv har opstillet.

Generelt er det som udgangspunkt en god idé at benytte de værktøjer, Google selv stiller til rådighed. Det fungerer som en god indikator for, hvilke krav Google gerne vil have din hjemmeside til at leve op til.

Google Search Console

Google Search Console er et uundværligt værktøj for dig, der gerne selv vil arbejde med SEO. Så hvis du ikke allerede benytter det, så anbefaler Jonas Venning Larsen, at du opretter det med det samme.

Nedenfor gennemgår vi nogle af de funktioner i Google Search Console, der giver potentiale for at forbedre din hjemmesides synlighed i Google.

Robots.txt

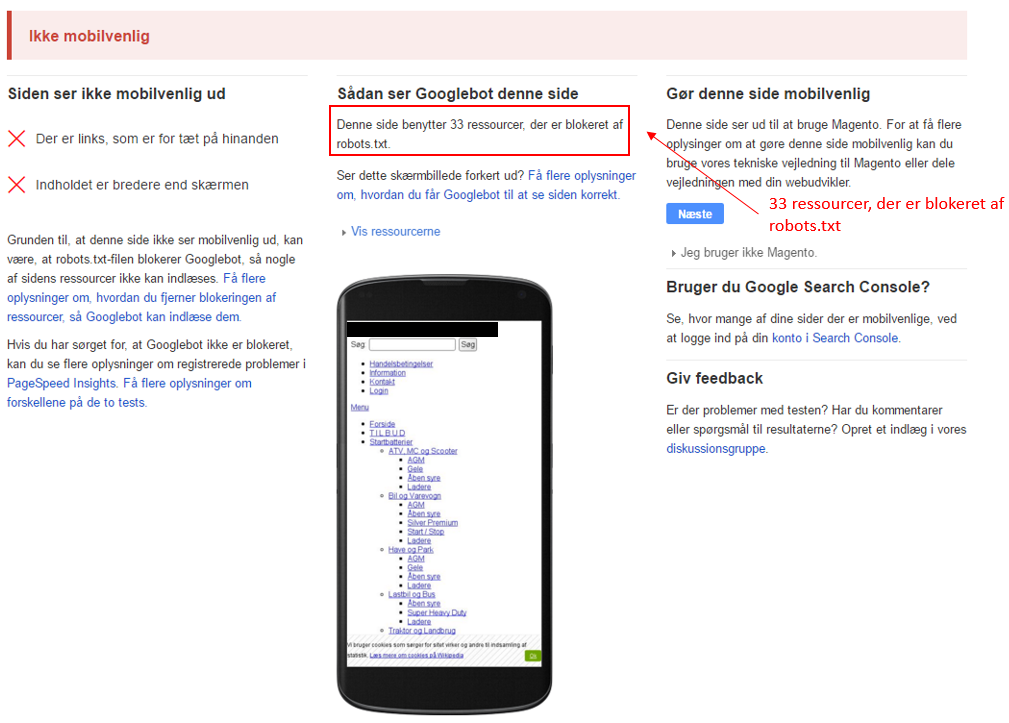

En Robots.txt fil kan bruges til at definere for Googlebot, hvilke sider den ikke skal gennemgå. Dette kan for eksempel være checkout-sider. Det er dog lige så vigtigt, at du ikke blokerer for ressourcer, der skal bruges til at gennemgå siden korrekt. Blokerer du de forkerte ressourcer, så kan det betyde, at din ellers mobilvenlige hjemmeside bliver set som ikke mobilvenlig af Google. Ved at køre din hjemmeside igennem Googles test af mobilvenlighed, så får du oplyst, hvorvidt Google ser din hjemmeside som mobilvenlig. Det er altså en god ide at benytte sig af testen – selvom du ved, din hjemmeside er mobilvenlig, da den viser, om din robots.txt blokerer for nødvendige ressourcer.

Billedet her viser en hjemmeside, der er optimeret til mobilvisning, men Google vurderer ikke hjemmesiden som mobilvenlig fordi vigtige ressourcer er blokerede.

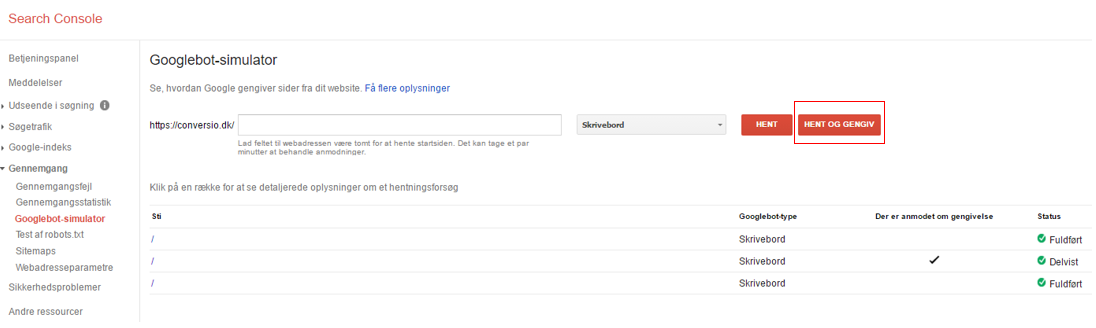

I Google Search Console har du ligeledes mulighed for at se, om Googlebot gennemgår din side korrekt på både mobilvisning og desktop. Du finder funktionen under ”Googlebot-simulator”.

Her kan du teste de forskellige sider, du har på din hjemmeside, hvis du vil teste forsiden, så trykker du på ”hent og gengiv”. Når den er kørt igennem trykker du ind på siden nedenfor, hvor du vil se nedenstående billede.

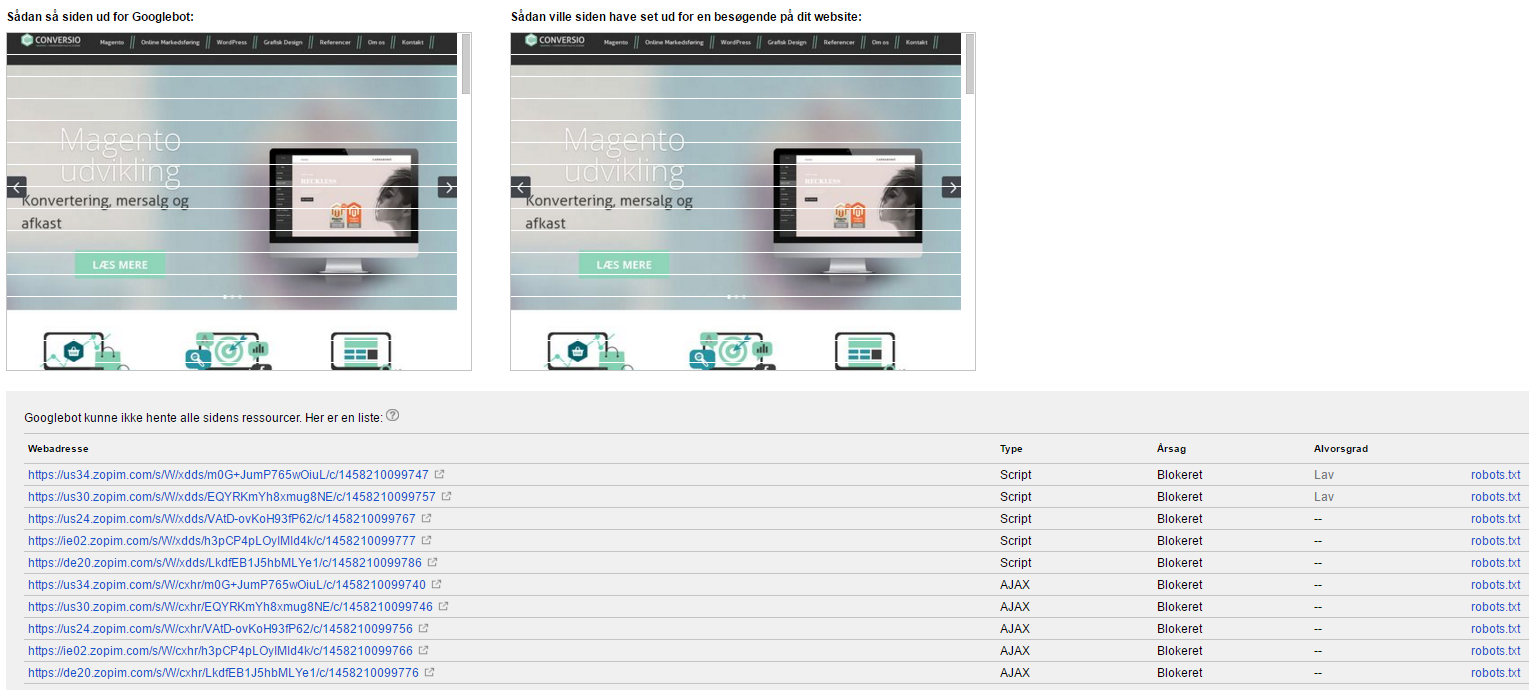

Her kan du se, hvordan siden ser ud for henholdsvis Googlebot og dine besøgende. Hvis der er forskel, så er det fordi, der er blokeret for ressourcer i Robots.txt filen. Det vil typisk være CSS og javascript, der er blokerede. Listen under visningerne viser, hvilke ressourcer Googlebot ikke er i stand til at hente – der vil ofte være blokeret for eksterne ressourcer som Zopim i dette tilfælde, hvilket der ikke kan gøres så meget ved. Men alle de interne ressourcer kan der gøres noget ved.

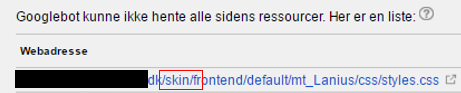

Du kan identificere problemet ved at se, hvilke mapper, der er blokerede. Nedenstående eksempel viser, at det er mappen /skin, der er blokeret i robots.txt. Du vil med stor sandsynlighed have linjen ”Disallow: /skin” i din robots.txt, som du så skal fjerne.

XML-sitemap

Et XML-sitemap fungerer som en form for guide til, hvordan søgerobotterne skal gennemgå en given hjemmeside. Dette gør det nemmere for søgerobotterne at få et overblik over, hvilke sider man ønsker skal indekseres. Det giver en hurtigere gennemgang af hjemmesiden. Det har betydning, hvor hurtigt søgerobotterne er i stand til at gennemgå en hjemmeside, og hvor mange sider den gennemgår. Jo hurtigere gennemgangen er, jo oftere kommer søgerobotterne på besøg og indekserer nye sider.

Et XML-sitemap har også den fordel, at det viser hvilke sider, der er de vigtigste, og hvornår den senest er blevet opdateret.

At lave et XML-sitemap fra bunden er ofte en lang proces, hvis du gør det manuelt. Men der findes flere værktøjer på nettet, som gør det muligt at generere det automatisk og typisk er det også noget de fleste CMS-systemer kan klare.

XML-sitemap skal uploades i Google Search Console, så søgemaskinerne bliver opmærksomme på, at det findes. Du kan fikse det under sitemaps i menuen. Derudover bør du implementere i robots.txt filen, ved at indsætte ”sitemap: URL’en for sitemappet”.

Eksempel:

Sitemap: http://www.domæne.dk/sitemap.xml

Hvis hjemmesiden overstiger mere end 50.000 URL’s, så skal jeres XML-sitemap deles op i flere mindre sitemaps.

Læs mere om XML-sitemap protokollen her: http://www.sitemaps.org/protocol.html

Forhåbentligt giver det dig nogle værktøjer til at gennemgå nogle af de tekniske elementer, der bør være i orden på din hjemmeside. Hvis du har svært ved at gennemskue det hele, så laver jeg gerne en Gratis SEO light analyse til dig, der gennemgår ovenstående og andre elementer.